开篇故事:从游戏显卡到AI引擎

20年前,显卡只是给电脑“打游戏、渲染画面”的小配件。

但谁能想到,如今它已经成了支撑 ChatGPT、自动驾驶、超级计算机 的核心武器。

为什么一块“显卡”,能撑起整个AI产业?

答案,就藏在 GPU 的设计逻辑里。

一、CPU vs GPU:大将军 vs 小士兵

CPU(中央处理器):

核心少(一般 4~128 核),每个核超强。

善于处理逻辑复杂、顺序执行的任务。

就像一位“大将军”,能精准指挥,但人手有限。

GPU(图形处理器):

拥有成千上万个计算核心(CUDA Core)。

擅长同时做大量重复计算(并行计算)。

就像一支“士兵大军”,不讲究单兵作战,而是靠数量取胜。

👉 深度学习本质上是 矩阵运算(乘法、加法),这正是 GPU 的强项。

二、为什么AI离不开GPU?

矩阵计算密集

神经网络训练,本质就是数百万次矩阵乘加。

GPU 并行处理能力,远超 CPU。

吞吐量优势

GPU 核心数量远大于 CPU,能同时处理上千条数据流。

AI框架优化

TensorFlow、PyTorch 等框架都深度绑定 GPU。

CUDA、cuDNN 等生态,让 GPU 成为 AI 的“标配”。

👉 没有 GPU,大模型训练可能要几年;有了 GPU,可以缩短到几周。

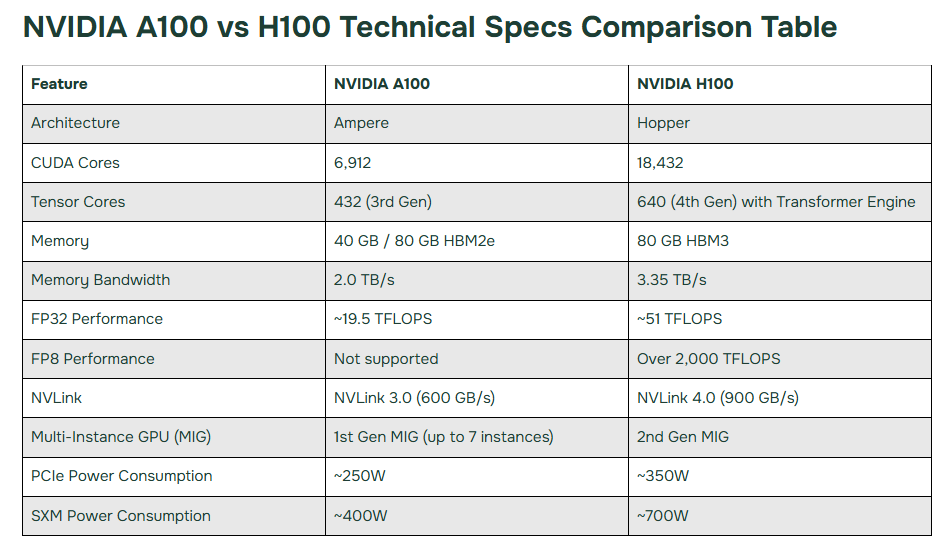

三、显卡算力的标杆:A100/H100

NVIDIA A100:

FP32 算力约 19.5 TFLOPS

专为 AI 设计,支持 Tensor Core

被誉为“AI训练神器”

NVIDIA H100(2022发布):

算力提升至 60+ TFLOPS

更强的 Transformer 加速引擎

被 OpenAI、Google DeepMind 大规模采用

一张 A100 售价高达十几万元人民币,却依旧“一卡难求”。

四、GPU在算力中心的地位

在算力中心:

CPU:负责调度、控制、数据预处理。

GPU:负责核心计算,尤其是深度学习和科学模拟。

NPU/TPU:专用芯片,做补充。

如果把算力中心比作军队:

CPU 是 将军;

GPU 是 主力士兵;

NPU/TPU 是 特种部队。

GPU 不仅是算力中心的中流砥柱,还成为国家级战略资源。

五、为什么GPU变得“稀缺”?

AI爆发:大模型训练对 GPU 需求量巨大。

芯片产能受限:先进制程(7nm、5nm)难度高,产量有限。

地缘政治:高端 GPU 芯片被列入战略物资,出口受限。

这导致 GPU 不只是 IT 产品,而是“算力时代的石油”。

六、结尾升华

显卡的命运,从“游戏工具”到“AI引擎”,折射了整个数字时代的转型:

过去比拼的是软件与算法;

现在比拼的是硬件与算力;

未来比拼的是 算力生态。

一句话总结:

没有 GPU,就没有今天的 AI;没有显卡,就没有算力中心的核心竞争力。

👉 下一讲,我们将继续探讨:从超级计算机到算力中心,算力演进的背后逻辑是什么?