开篇场景:一座“吃电怪兽”

有人调侃:一座算力中心,能一口吃掉一座小型水电站的电力。

这不是夸张。

一个中大型算力中心,耗电量常常以 百兆瓦(MW) 计;

相当于一个中等城市的居民用电需求。

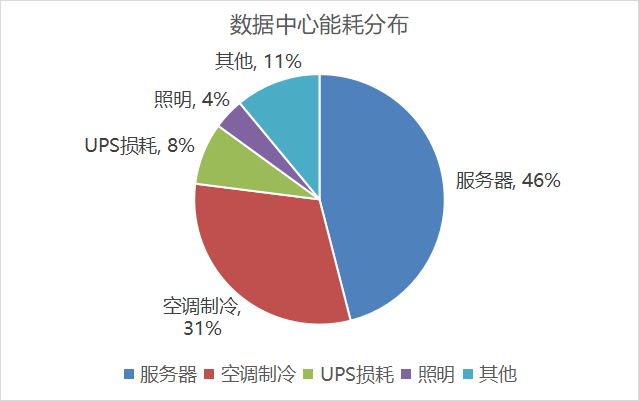

为什么算力中心这么耗电?除了算力本身,还有一个常被忽视的“隐性成本”——冷却。

一、为什么算力中心耗电惊人?

硬件高功耗

GPU/CPU 功耗:一张 NVIDIA A100 ≈ 400W;一张 H100 ≈ 700W。

一台 8 卡服务器 ≈ 3kW;1万台服务器 ≈ 30MW。

24小时运行

算力中心不能停机,全年无休。

冷却系统

计算设备产生大量热量,需要持续冷却。

冷却耗电往往与计算耗电接近,甚至超过。

算力中心的电,差不多有一半被用来“降温”。

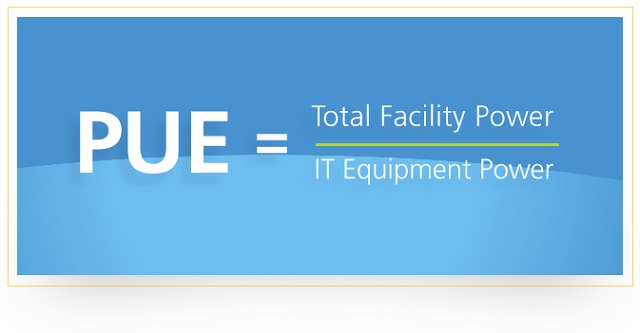

二、PUE:衡量能效的关键指标

PUE(Power Usage Effectiveness)= 数据中心总能耗 ÷ IT设备能耗。

理想值 = 1.0(所有电力都用于计算)。

传统机房:PUE ≈ 2.0。

优秀算力中心:PUE ≈ 1.2 ~ 1.3。

这意味着:

一座普通机房,只有 50%电力用于计算;

另一半都浪费在冷却、输配电。

三、冷却方式的演进

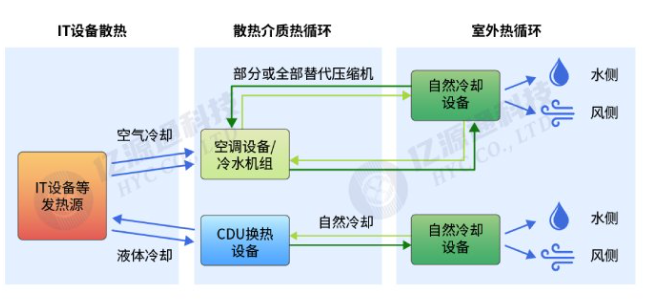

风冷(早期主流)

通过空调和风机降温。

成本低,但能效差。

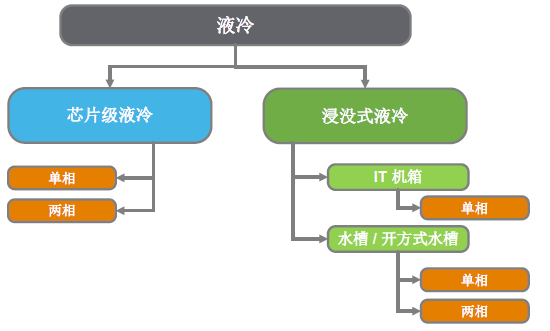

液冷(新兴主流)

冷却液直接接触硬件,带走热量。

更节能、更高效。

已在高端超算和算力中心普及。

浸没式冷却(前沿探索)

整个服务器浸入绝缘液体。

热交换效率高,PUE 可低至 1.05。

技术门槛高,但未来潜力巨大。

冷却技术决定了算力中心的生死线。

四、真实案例:能耗账单

美国一家超大规模数据中心:耗电 300MW,相当于 30万户家庭用电。

中国“东数西算”工程:部分西部数据中心选址在水电资源丰富地区,利用清洁能源 + 低温气候降低能耗。

华为、腾讯等厂商:大规模采用液冷,PUE 已降至 1.2 以下。

算力不仅是硬件之争,更是 能源与能效之争。

五、绿色算力:未来的方向

可再生能源:风能、光伏、水电,减少碳排放。

液冷技术普及:延长硬件寿命,降低运营成本。

智能调度:根据用电谷峰时段,动态分配算力任务。

碳中和目标:算力中心将被纳入国家“双碳”战略。

六、结尾升华

算力中心不仅是“数字工厂”,更是“耗电怪兽”。

谁能降低 PUE,谁就能在竞争中活下去;

谁能用上绿色能源,谁就能掌握未来算力的制高点。

一句话总结:

算力的比拼,不只是速度和规模,更是能效与可持续。

下一讲,我们将聚焦国家战略级工程——“东数西算”:算力的空间调度与区域格局。