⚠️ 声明:本文为 IT 技术与架构科普内容,仅供学习交流,不构成任何厂商或产品推荐。

一、为什么异构数据同步如此重要?

在一个典型的大型企业里,往往同时存在:

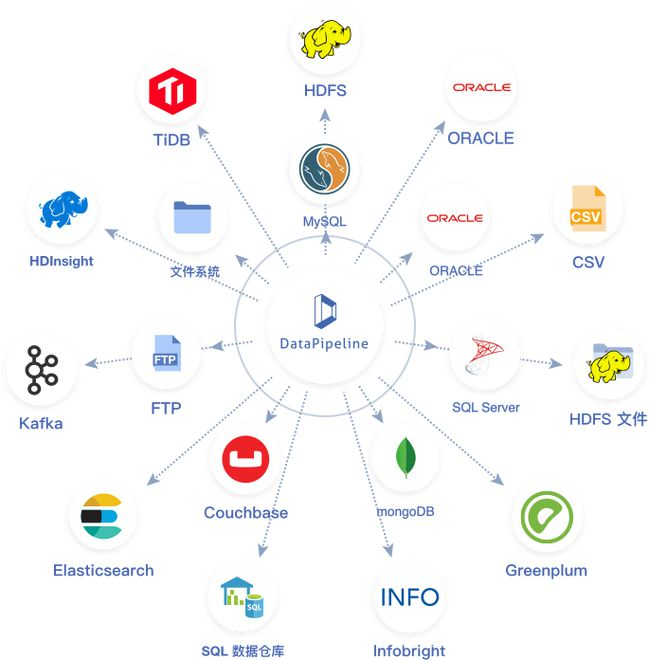

不同数据库:Oracle、MySQL、PostgreSQL、SQL Server、国产数据库(达梦、OceanBase、TiDB…)

不同存储:HDFS、对象存储(OSS/S3/MinIO)、日志系统(Kafka)、搜索引擎(Elasticsearch)

不同业务系统:ERP、CRM、财务系统、OA、生产系统

这些系统之间的数据格式、接口、更新频率完全不同。

👉 如果不能实现 异构数据的同步与集成,就会出现:

数据孤岛 → 财务和业务报表无法统一;

数据延迟 → 决策依赖的不是实时数据;

成本高昂 → 各部门重复存储、重复建设。

因此,“如何让不同来源的数据实现同步”成为 数据中台、数据湖、主数据管理 的关键课题。

二、异构数据同步的核心挑战

数据模型不同

Oracle 用表空间,MySQL 用库表,MongoDB 用文档存储,如何统一?

数据类型不一致

不同数据库的字段类型(如 DATE vs DATETIME,NUMBER vs DECIMAL)往往不能直接对应。

增量捕获难度

如何识别“哪些数据发生了变化”?全量同步成本高,增量同步更高效,但更复杂。

事务一致性

跨系统同步时,如何保证“源库和目标库的数据一致”?

实时 vs 批处理

有些业务需要 准实时(风控系统),有些业务允许 T+1 批处理(财务报表)。

三、异构数据同步的常见技术路径

1. ETL(Extract-Transform-Load)

原理:先抽取(Extract),再转换(Transform),最后装载(Load)。

特点:

适合 批处理 场景(如夜间跑批);

典型工具:Informatica、Kettle、Talend、国产 FineBI/FineETL。

不足:实时性差。

2. 数据库日志解析(CDC,Change Data Capture)

原理:通过解析数据库 redo log/binlog,捕获增量变化,再推送到目标端。

特点:

高效,无需全表扫描;

可做到实时同步。

典型实现:Debezium、Canal、OGG(Oracle GoldenGate)、DTS(云数据库同步服务)。

不足:配置复杂,对源数据库权限要求高。

3. 消息队列中转

原理:源系统变更 → 推送到消息队列(Kafka、RocketMQ、Pulsar) → 下游系统订阅消费。

特点:

支持多源写入、多目标分发;

具备削峰填谷能力。

不足:需要额外的消息队列基础设施。

4. 数据虚拟化(Data Virtualization)

原理:不做物理同步,而是通过中间层统一访问异构源(如 Presto、Trino、Dremio)。

特点:

查询时实时获取,避免多份存储;

更适合 分析场景。

不足:性能依赖源系统,不适合高并发写入。

四、架构模式选择

五、异构数据同步的最佳实践

明确目标

是要构建 数据仓库,还是 实时风控平台?不同目标决定架构。

分层处理

源系统层:只做数据采集,尽量减少入侵;

中间层:清洗、标准化、打标签;

目标层:存入数据湖、数仓或搜索引擎。

数据标准化

定义统一的数据类型映射规则;

建立主数据、元数据管理平台。

监控与审计

必须具备延迟监控、失败重试、数据比对机制,保证同步质量。

结合国产替代

Oracle → 达梦/金仓/OceanBase;

Kafka → RocketMQ/Pulsar;

逐步实现信创环境的数据同步方案。

六、实际案例(简化版)

某大型银行需要实现:

Oracle 交易库 → 实时同步到 OceanBase(双活架构,做核心交易容灾);

MySQL 网银库 → 每天全量 ETL 到 Hadoop(用于离线风控分析);

交易日志 → Kafka → Elasticsearch(用于实时查询)。

最终采用 CDC + MQ + ETL 混合架构:

OGG 解析 Oracle 日志,实时推送到 OceanBase;

Kettle 每日跑批,将 MySQL → Hadoop;

Kafka 中转日志,供多系统消费。

👉 实现了 实时、批处理、分析 的全链路打通。

七、结语

异构数据同步并非“一招鲜吃遍天”,而是要结合:

业务实时性要求

系统兼容性与安全性

企业 IT 战略(如信创国产化)

合理选择 ETL、CDC、MQ、虚拟化等方式,才能让数据真正 从孤岛走向融合,为 数据中台、智能分析、业务创新 提供坚实基础。

数据,不仅要存得下,更要流得动。

⚠️ 声明:本文为 IT 架构与数据治理科普,仅供学习与研究参考,不构成任何厂商推荐或实施方案。